# 如何在本地部署DeepSeek R1?Windows/Mac适用

目录

# 1.前言

国产大模型DeepSeek R1推出后效果炸裂,生成质量秒杀ChatGPT,很多朋友问如何私有化部署到本地使用,所以写一篇详细部署教程给家人们。

# 2.DeepSeek模型显卡和 macOs运行内存需求表

这是DeepSeek R1对应参数的性能需求,根据自身硬件来部署对应模型。

| 模型大小 | 显存需求(FP16推理) | 显存需求(INT8推理) | 推荐显卡 | macOS 需要的 RAM |

|---|---|---|---|---|

| 1.5B | ~3GB | ~2GB | RTX 2060/Mac M系列 | 8GB |

| 7B | ~14GB | ~10GB | RTX 3060 12GB/4070 Ti/Mac M系列 | 16GB |

| 8B | ~16GB | ~12GB | RTX 4070 /Mac M系列 | 16GB |

| 14B | ~28GB | ~20GB | RTX 4090 /A100 40G | 32GB |

| 32B | ~64GB | ~48GB | 2xRTX 4090 /A100 80G | 64GB |

# 3.安装Ollama

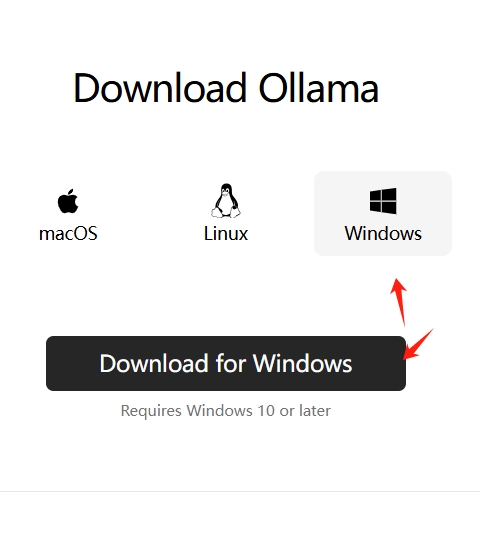

下载Ollama,根据当前系统选择版本

https://ollama.com/download (opens new window)

Windows

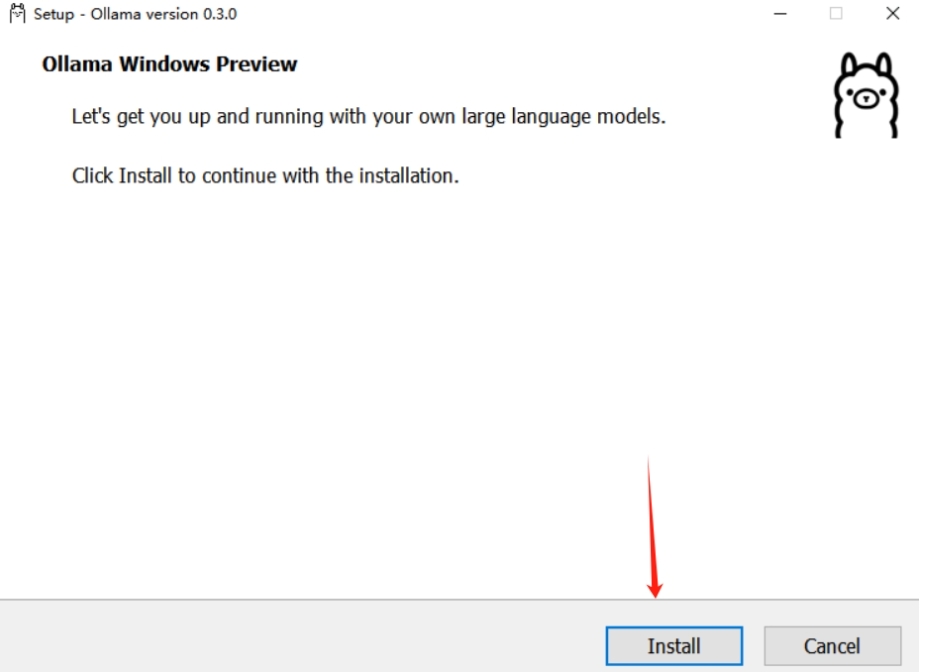

等待下载完毕,双击OllamaSetup.exe,点击install

如下界面说明成功

macOS

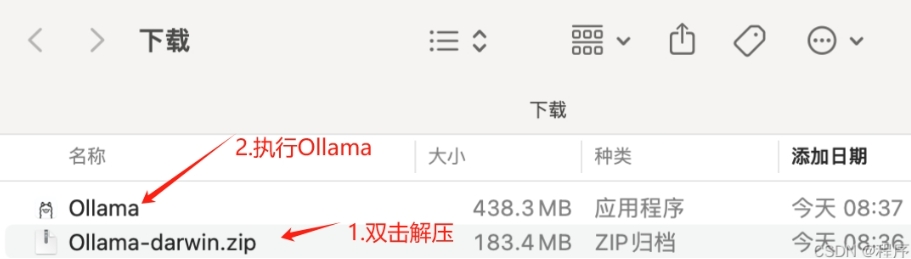

等待下载完毕,解压Ollama-darwin.zip

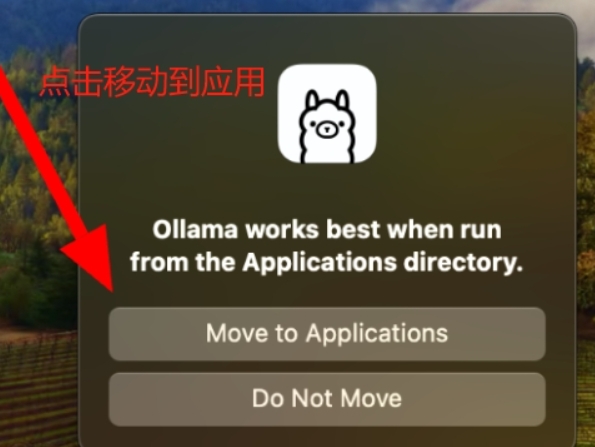

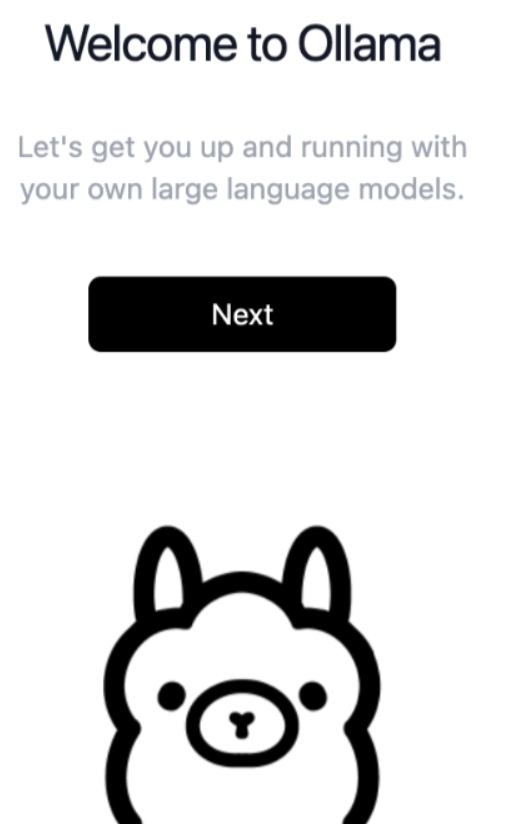

运行Ollama,移动到应用

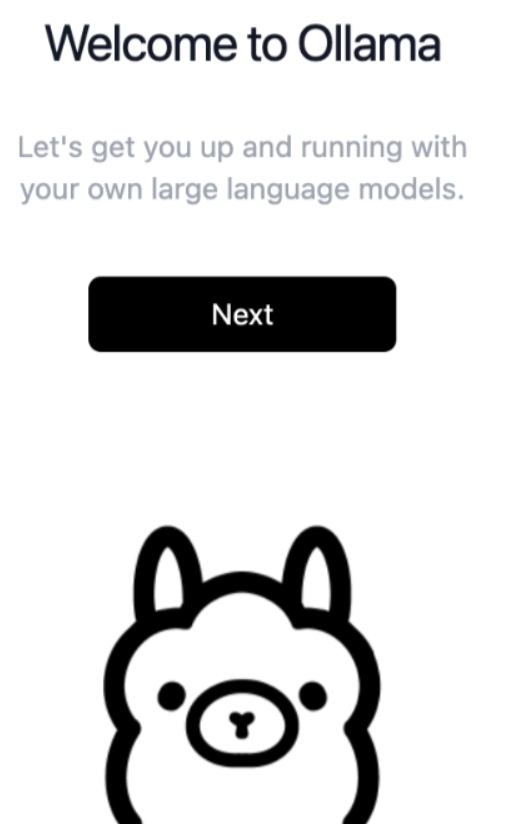

如下界面说明成功

# 4.安装DeepSeek R1

打开命令行

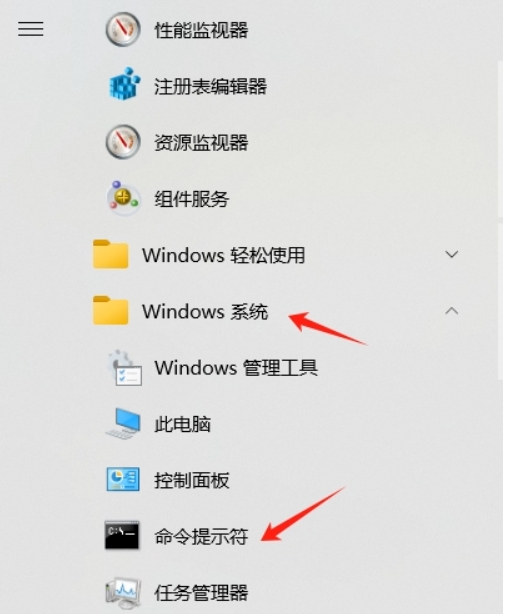

Windows

macOS

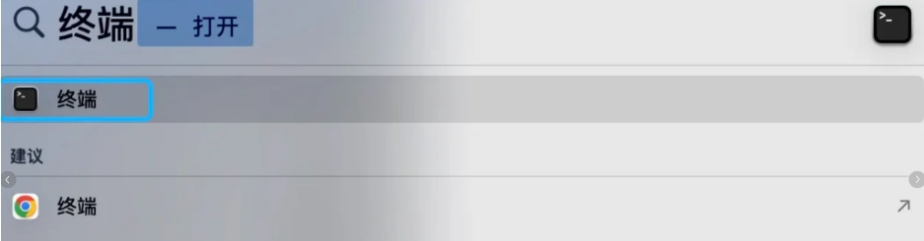

搜索终端

在命令行运行安装输入命令

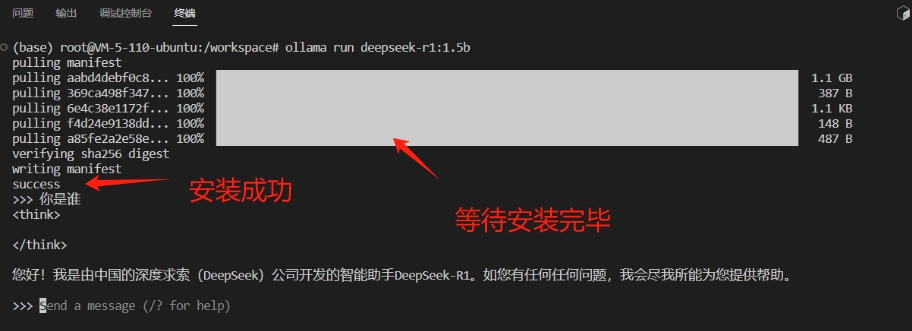

ollama run deepseek-r1:1.5b

等待安装成功,出现success说明安装成功

# 错误排查

# 找不到主机

"Error: error reading llm response: read tcp 127.0.0.1:49245->127.0.0.1:49210: wsarecv: An existing connection was forcibly closed by the remote host."

出现这种情况一般是dns问题,把系统dns改为8.8.4.4即可